360智脑团队宣布推出全新的Light-IF系列模型,这一创新框架旨在显著提升大型语言模型(LLM)在复杂指令遵循方面的能力。随着人工智能技术的不断进步,尽管LLM在数学、编程等领域已经展现出了卓越的推理能力,但在遵循复杂指令方面仍存在不足。为了解决这一问题,360智脑团队提出了以预览-自检式推理和信息熵控制为核心的Light-IF框架。

Light-IF框架通过五个关键环节来提升模型性能:难度感知指令生成、Zero-RL强化学习、推理模式提取与过滤、熵保持监督冷启动、熵自适应正则强化学习。这一框架的提出,旨在破解当前推理模型中存在的“懒惰推理”现象,即模型在思考阶段仅复述指令而不主动检查约束是否被满足,导致指令执行不准确的问题。

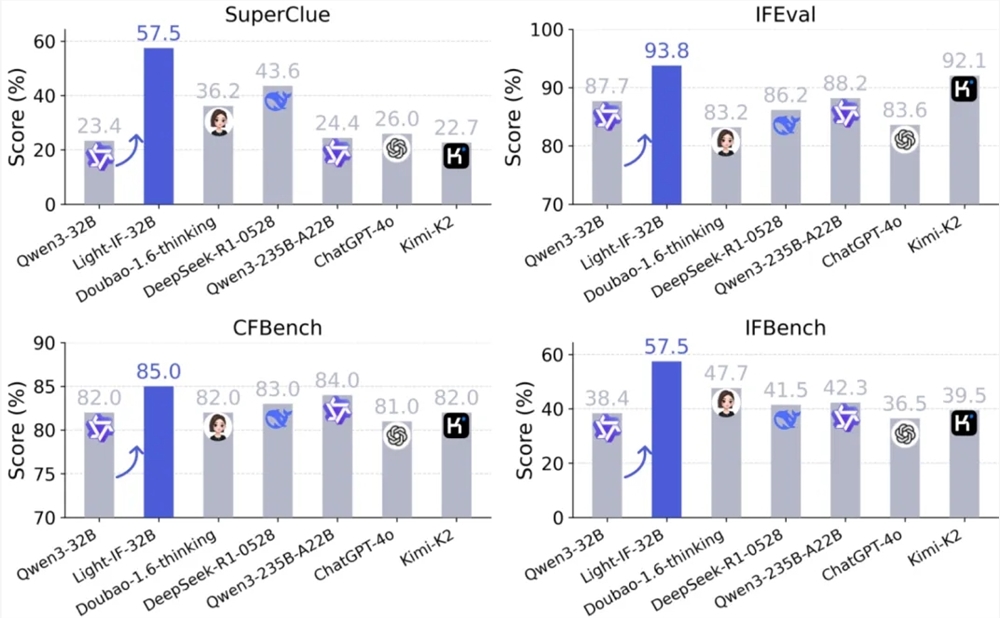

在实验中,Light-IF系列模型在SuperCLUE、IFEval、CFBench及IFBench四个中文和跨语言指令遵循基准上均取得了显著提升。特别是32B版本的Light-IF-32B,其在SuperClue得分达到了0.575,比下一个最佳模型高出13.9个百分点。此外,参数规模仅为1.7B的Light-IF-1.7B在SuperClue和IFEval上的表现甚至超过了Qwen3-235B-A22B等体量更大的模型。

360智脑团队表示,Light-IF系列模型的推出,不仅为开源社区提供了一套可复现的完整路线和配套的开源代码,而且全系模型将陆续在Hugging Face上开放,供社区使用、对比与复现。同时,训练中使用的冷启动数据集也将同步在GitHub上开放。此外,360与SuperCLUE联合推出的中文精确指令遵循测评基准SuperCLUE-CPIFOpen也将在Github上开放,便于研究者评测模型的中文精确指令遵循能力。

这一新模型的推出,标志着360智脑在提升人工智能模型复杂指令遵循能力方面迈出了重要一步,为人工智能技术的发展和应用开辟了新的可能性。